Ein Large Language Model (LLM) wie z.B. GPT-4 funktioniert ähnlich wie ein sehr erfahrener und gut informierter Gesprächspartner, der in der Lage ist, auf eine Vielzahl von Fragen und Themen zu antworten. Um zu verstehen, wie ein LLM funktioniert, können wir es mit dem Erlernen einer Sprache durch einen Menschen vergleichen:

- Lernen aus großen Datenmengen: Stellen Sie sich vor, jemand liest Millionen von Büchern, Artikeln und Webseiten. Dieser Jemand lernt dadurch, wie Sprache funktioniert, erkennt Muster, versteht verschiedene Kontexte und sammelt ein breites Wissen über viele Themen. Ein LLM macht genau das: Es wird mit einer riesigen Menge an Texten trainiert und lernt so, wie Wörter und Sätze normalerweise verwendet werden.

- Verstehen und Vorhersagen: Wenn Sie das LLM etwas fragen, sucht es in seinem gelernten Wissen nach Mustern, die zu Ihrer Frage passen. Es versucht dann, basierend auf diesen Mustern eine passende Antwort zu generieren. Das ist ähnlich, wie wenn Sie selbst etwas sagen möchten: Sie denken darüber nach, was Sie wissen, und wählen dann die Wörter, die Ihre Gedanken am besten ausdrücken.

- Antwortgenerierung: Das LLM generiert Antworten durch das Vorhersagen von Wortfolgen. Es wählt jeweils das nächste Wort basierend darauf aus, was am wahrscheinlichsten sinnvoll ist, basierend auf den Millionen von Texten, die es gelesen hat. Das ist so, als ob Sie beim Sprechen jedes nächste Wort basierend auf dem Kontext und Ihrem Wissen auswählen.

- Lern- und Anpassungsfähigkeit: Ein LLM kann sich auch weiterentwickeln und lernen. Wenn es neue Informationen oder Korrekturen erhält, kann es seine Antworten in der Zukunft verbessern. Dieser Prozess ist vergleichbar mit dem lebenslangen Lernen eines Menschen.

Zusammengefasst funktioniert ein LLM also, indem es eine riesige Menge an Texten analysiert, daraus lernt und dann diese Informationen nutzt, um auf Anfragen zu antworten. Es ist ein sehr komplexes System, das in der Lage ist, menschliche Sprache auf einem hohen Niveau zu verstehen und zu imitieren.

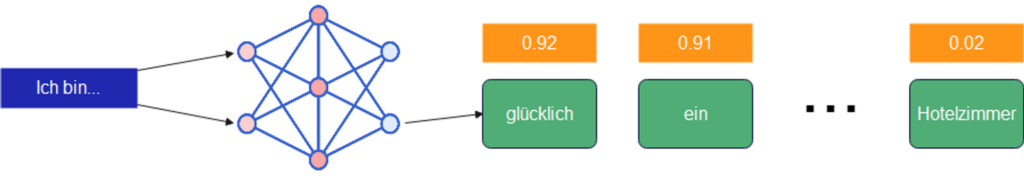

Man muss erwähnen, dass es trotz aller Komplexität und Datenmengen, keine eigene Intelligenz hervorbringt. Basierend auf einem Eingabetext berechnet es die Wahrscheinlichkeit für das Nächste Wort in Folge. Sehen wir uns ein Beispiel an:

Die Wörter “Ich bin” werden als Input für ein LLM benutzt. Dieser verarbeitet auf Basis bestimmter Algorithmen und seinen gelernten Parametern den Input und gibt am Ende eine Wahrscheinlichkeit für ein bestimmtes Wort im Vokabular aus, welches auf die Wörter “Ich und bin” folgen könnte. Die orangefarbenen Kästchen spiegeln die Wahrscheinlichkeiten aller Wörter im Vokabular wieder. Vokabular bedeutet hier alle möglichen Wörter in einer bestimmten Sprache. Im Deutschen Vokabular sind schätzungsweise 300.000 bis 500.000 Wörter.

Fun Fact: Ein durchschnittlicher Deutscher hat zwischen 12.000 – 16.000 Wörter in seinem Wortschatz. Goethes aktiver Wortschatz lag bei ca. 90.000 Wörtern!

Natürlich wird das LLM nicht auf jedes “Ich bin” immer wieder mit “glücklich” antworten. Denn es gibt ein besonderes Merkmal von LLMs, speziell das von OpenAI (GPT). Es besitzt einen sogenannten Attention Mechanismus. Dieser evaluiert die Wahrscheinlichkeit nicht nur basierend auf das letzte Wort davor, sondern auf den gesamten Kontext der aktuellen Diskussion / Chats. Doch dazu später mehr.

Im großen und ganzen ist das alles. Eingabe→Wahrscheinlichkeit für das nächste Wort berechnen→ Ausgabe von Wahrscheinlichkeiten für das nächste Wort. Es tut mir leid, wenn ich den Mythos ChatGPT und dem wilden Traum einer eigenen Intelligenz zerstört habe. Aber unterm Strich ist das genau das Ergebnis.

Aber, wie man dahinkommt, also das Training des Modells, das ist wirklich High Tech. So ein LLM hat viele andere Komponenten, wird werden eine nach der anderen kennenlernen. Und wir sind nicht am Ende. Es gibt viele alternative und konkurrierende Modelle. Google hat neulich sein Modell Gemini vorgestellt, welches in dem Chatbot BARD implementiert ist. Das soll das aktuell beste LLM, GPT-4 von OpenAI schlagen. Und viele anderen stehen in den Startlöchern. Elon Musk mit Grok, Anthropic mit dem erwähnten Claude2, Facebook mit LLama2, usw. usw. Jedoch sind nicht nur die Modelle an sich hochinteressant und spannend für den Business Use Case, sondern die Möglichkeit diese in mit eigenen Daten anzureichern, diese und andere Tools und APIs zu kombinieren, um völlig neue Einsatzmöglichkeiten zu schaffen statt “nur” ein Chat. Wenn man möchte und das nötige Kleingeld hat, kann man auch sein eigenes Modell trainieren oder ein Foundation Modell tunen, um einem LLM den Kontext seines eigenen Unternehmens beizubringen.

Wir werden uns einige Beispiele im Zuge dieser Artikel- und Video Reihe anschauen.

Vorheriger Artikel in der Reihe LLMs: Was ist ein LLM?